Im Folgenden werden Manipulationstechniken eingeführt, die direkt auf der zu optimierenden Seite oder Domain ausgeführt werden. Die entsprechenden Aussagen zu diesen Techniken in den Google Webmaster Guidelines sind in Richtlinien für Webmaster zu finden.

Sneaky Redirects

Normalerweise sollte eine Weiterleitung mit der Aussendung eines entsprechenden http Status Codes (3xx) kenntlich gemacht werden. Suchmaschinen haben dann die Möglichkeit, die Webseite, die diesen Statuscode aussendet, aus dem Index zu entfernen und stattdessen das Ziel der Weiterleitung zu indexieren. Es ist jedoch auch möglich, einen Redirect über andere Techniken wie zum Beispiel JavaScript zu realisieren. Damit ist es möglich, dass eine Seite im Index der Suchmaschinen auftaucht, obwohl sie eine Weiterleitung enthält. Diese Technik wird auch häufig in Zusammenhang mit Doorway Pages angewandt.

Doorway Pages

Suchmaschinen können die Qualität eines Textes nicht in gleichem Maße bewerten, wie ein menschlicher User. Sie sind auf maschinell auswertbare Informationen angewiesen. Doorway Pages sind auf genau diese Informationen optimiert, ohne dabei auf den menschlicher User zu achten. Dadurch verschaffen sie sich Vorteile gegenüber für Menschen optimierten Webseiten und werden unter Umständen auf guten Positionen gelistet.

Hidden Text

Suchmaschinen möchten ihren Benutzern diejenigen Webseiten ausliefern, auf denen sie die gewünschten Informationen zu ihrer Anfrage finden können. Webseiten basieren jedoch meist auf HTML, das vom Browser entsprechend gerendert wird. Dadurch ist es möglich, Text – für eine Maschine lesbar – im Quelltext zu hinterlegen, der jedoch für einen menschlichen Besucher unsichtbar ist. Dies kann zum Beispiel mit diversen CSS Eigenschaften, wie etwa display:none; text-indent:-9999; visibility:hidden; etc. erreicht werden. Der folgende Quellcodeausschnitt zeigt dies exemplarisch.

<div style="display:none;">Dieser Text ist unsichtbar</div>

Keyword Stuffing

Die Anzahl des Vorkommens eines Keywords hat einen Einfluss auf das Ranking bei Suchmaschinen. Der entsprechende Einflussfaktor wird als Keyword Density bezeichnet. Eine übertrieben hohe Nennung eines Keywords kann als Manipulationsversuch ausgelegt werden. Keyword Stuffing tritt auch häufig in Zusammenhang mit hidden Text auf. Konkrete Werte für die maximale Keyword Density sind nicht bekannt und man geht davon aus, dass diese Schwelle auch von anderen Faktoren abhängig ist bzw. nur in Kombination mit anderen Faktoren zu einer Abstrafung führt.

Cloaking

Beim Cloaking werden unterschiedliche Informationen für die Spider eine Suchmaschine und die menschlichen Besucher ausgeliefert, obwohl die gleiche URL aufgerufen wird. Dies kann zum Beispiel an Hand der User Agent Kennung geschehen, die der Bot einer Suchmaschine beim Aufruf einer Seite mitsendet. Eine weiterer Möglichkeit besteht in der Abfrage der IP Adresse, da die Spider einer Suchmaschinen meist von den gleichen IP Adressen aus die Webseiten abrufen.

Mit dieser Technik kann dem Spider eine für Suchmaschinen optimierte Webseite ausgeliefert werden, während ein menschlicher Benutzer etwas ganz anderes zu sehen bekommt.

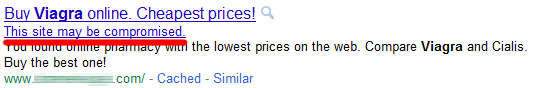

Malware

Die Verbreitung von Viren, Trojaner und anderer Mal- und Spyware ist untersagt. Infizierte Webseiten werden zunächst in den Suchmaschinenergebnissen markiert, wie in der unteren Abbildung beispielhaft zu sehen ist. Bei länger anhaltender Infizierung kann jedoch auch eine komplette Entfernung aus dem Index stattfinden. Seit dem 1. März 2010 benachrichtigt Google den Betreiber der infizierten Seite, sofern die Seite in den Google Webmaster Tools angemeldet ist.

Duplicate und shallow Content

Im Februar 2011 wurde von Google ein Update des Algorithmus vorgenommen, das unter dem Namen Panda Update bekannt wurde. Ziel dieses Updates war die Verbesserung der allgemeinen Qualität der Suchmaschinenergebnisse. Als Resultat dieses zur Zeit (Stand Juni 2011) nur in englischsprachigen Ländern aktiven Updates wurden etwa 12% der Suchanfragen betroffen und vor allem Contentfarmen und reine Aggregatoren haben stark an Sichtbarkeit verloren. Contentfarmen zeichnen sich dadurch aus, dass sie sehr viel Content in meist minderwertiger Qualität (sogenannten shallow Content) bereitstellen, während Aggregatoren die Inhalte verschiedener Seiten zusammenkopieren, wodurch sich eine duplicate Content Situation ergeben kann.

Das Vorhandensein von duplicate und/oder shallow Content kann zur Abstrafung einer ganzen Domain führen, wie das folgende Zitat aus The Farmer/Panda Update: New Information From Google and The Latest from SMX West verdeutlicht:

Bear in mind that people searching on Google typically don’t want to see shallow or poorly written content, content that’s copied from other websites, or information that are just not that useful. In addition, it’s important for webmasters to know that low quality content on part of a site can impact a site’s ranking as a whole. For this reason, if you believe you’ve been impacted by this change you should evaluate all the content on your site and do your best to improve the overall quality of the pages on your domain. Removing low quality pages or moving them to a different domain could help your rankings for the higher quality content.

Die genauen Einflussfaktoren, die letztendlich zur Abstrafung (meist in Form einer Ranking Rückstufung) führen, sind bisher noch nicht bekannt. Als Anhaltspunkt gibt es jedoch einen offiziellen Fragenkatalog von Google, mit dessen Hilfe der Inhalt einer Seite qualitativ bewertet werden kann.