Als Duplicate Content bezeichnet man den Inhalt von Dokumenten im Web, die dem Inhalt anderer Dokumente stark ähneln beziehungsweise sogar gleichen, wobei ein Dokument dabei genau von einer URL identifiziert wird. Für Benutzer von Google macht es keinen Sinn, die gleiche Information mehrfach angezeigt zu bekommen. Deshalb versucht man Duplikate zu erkennen und bei der Berechnung der SERPs auf ein einziges, repräsentatives Ergebnis zu beschränken. Auf der letzten Seite der Suchergebnisse finder sich deshalb häufig der Hinweis

Um Ihnen nur die treffendsten Ergebnisse anzuzeigen, wurden einige Einträge ausgelassen, die den n bereits angezeigten Treffern sehr ähnlich sind.

Auf MyWebsolution wird die Duplicate Content Thematik vor allem aus Sicht externer Duplicate Content Probleme behandelt und es wird ein Algorithmus vorgestellt, durch den Google Duplicate Content erkennen kann.

Probleme durch Duplicate Content

Für eine Homepage können sich aus Googles „Feature“ der Duplicate Content Erkennung einige Probleme ergeben, wenn diese Homepage Seiten beinhaltet, die den gleichen Inhalt über verschiedene URLs ausliefern (sogenannter interner Duplicate Content). Bevor diverse Lösungen zu der Duplicate Content Problematik vorgestellt werden, folgt zunächst ein kurzer Abschnitt zu Situationen, in denen Duplicate Cotent häufig auftritt.

mit-oder-ohne-www – potenzieller Duplicate Content

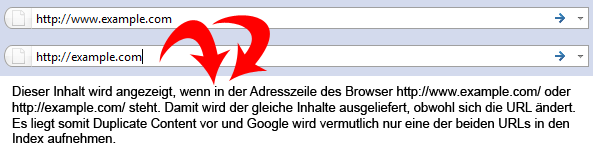

Das prominenteste Beispiel ist die Erreichbarkeit einer Seite mit der beziehungsweise ohne die Eingabe der www. Standardsubdomain:

- http://www.example.com/

- http://example.com/

In vielen Fällen ist zusätzlich noch eine Standarddatei definiert, die bei der Eingabe des Domainnamens angezeigt wird. Unter der Annahme, dass es sich dabei um die Datei index.html handelt, ist zusätzlich noch die URL http://www.example.com/index.html erreichbar und liefert den gleichen – und somit Duplicate – Content. Die folgende Grafik verdeutlicht dieses Beispiel.

Die mit-oder-ohne-www-Problematik ist umso schlimmer, da es meist nicht nur auf die Startseite zutrifft, sondern Duplicate Content auf jeder einzelnen Unterseite auftritt!

Das eigentliche Problem dabei ist die Tatsache, dass alle Versionen eigene, eingehende Links besitzen können. Es macht aber keinen Sinn, diese Links auf mehrere URLs aufzuteilen, sondern die Power der Links in einer einzigen URL zu konsolidieren. Zwar unternimmt Google Versuche, diese Konsolidierung automatisch vorzunehmen, aber es gibt keine Garantie dafür, dass dies auch in allen Fällen funktioniert. Durch internen Duplicate Content wird also generell die Linkpower schlechter verteilt.

Ein weiteres Problem von Duplicate Content ist die von Google bevorzugte Variante der angezeigten URL. So könnte es zum Beispiel sein, dass Google die Domain in den Suchergebnissen ohne www. darstellt obwohl diese zum Beispiel auf Visitenkarten etc. stets mit www. gedruckt wird.

Druckversionen und Versionen für mobile Geräte

Eine HTML Seite eignet sich nur bedingt für den Druck, da sie in der Regel Elemente enthält, die keine für einen Ausdruck nützlichen Informationen zur Verfügung stellen (Navigation, Footer, etc.). Deshalb macht es aus Sicht der Usability Sinn, eine gesonderte Druckversion bereitzustellen. Diese muss irgendwie aufrufbar sein und besitzt demnach eine eigene URL. Gleichzeitig hat sie aber den gleichen Inhalt wie die Nicht-Druckversion, so dass eine Duplicate Content Situation entsteht.

Das gleiche Problem ergibt sich bei Homepages, die spezielle, für mobile Endgeräte optimierte Versionen einer Webseite zur Verfügung stellen. Wie auch bei der Druckversion werden hier einige Elemente der „originalen“ Webseite nicht auftauchen, aber der Contentbereich bleibt der Gleiche, so dass im Wesentlichen auch hier Duplicate Content vorliegt.

Navigationsstrukturen

Bei Webseiten mit mehrdimensionalen Navigationsstrukturen tritt häufig das Problem auf, dass eine Zielseite über verschiedene Pfade zu erreichen ist. Gerade bei Webshops gibt es häufig eine Einteilung in hierarchische Kategorien, wobei untergeordnete Kategorien zu verschiedenen Oberkategorie zugeordnet sind. Im englischen wird diese Art der Navigation als „faceted navigation“ bezeichnet. Ein Beispiel dazu:

- http://www.example.com/shop/moebel/stuehle/holzhocker.html

- http://www.example.com/shop/material/holz/holzhocker.html

Auch hier steht der Gedanke der Usability im Vordergrund, da das Produkt „Holzhocker“ verschiedenen Kategorien zugeordnet ist und auch auf den verschiedenen Kategorieseiten gelistet werden sollte. Nichtsdestotrotz entstehen dadurch unterschiedliche URLs mit dem gleichen Inhalt ergo Duplicate Content.

Parameterübergaben

Einer URL können nach der Angabe des Pfades, eingeleitet durch ein Fragezeichen, Parameter übergeben werden. URLs mit gleichen Pfaden aber unterschiedlichen Parametern werden wiederum von Suchmaschinen als eigenständige URLs gewertet. Dieses Verhalten macht Sinn, wenn man diese URL Parameter Beispiele bedenkt, bei denen der angezeigte Inhalt dynamisch aus einer Datenbank geladen und dabei durch einen ID-Parameter identifiziert wurde.

Parameter werden aber auch zu anderen Zwecken benutzt, wie zum Beispiel zur Identifizierung einer Session. Bei Benutzern, die Cookies deaktivieren wird dabei die Session ID an jeden internen Link auf einer Webseite angehangen. Dadurch entstehen URLs wie beispielhaft in der folgenden Liste dargestellt:

- http://www.example.com/?sid=0011e714c078160254e7374a476ab188

- http://www.example.com/?sid=be30908222d1a60fd8cf7800cfcaa7c7

- http://www.example.com/?sid=e6948c99d871291d0abd4bdbf4d5c7eb

Jede dieser unterschiedlichen URLs hat den gleichen Inhalt, so dass Duplicate Content entsteht.

Redundante Informationen in URLs

Die vorgestellte Lösung zur Optimierung der URL Strukturen mittels redundanten Informationen hatte das Problem, dass eine Seite über mehrere URLs zugreifbar war. Auch das führt dazu, dass Duplicate Content entsteht, denn der gleiche Seiteninhalt ist über verschiedene URLs aufrufbar.

Lösungen zu internem Duplicate Content

Es gibt verschiedene Lösungsstrategien für Duplicate Content Probleme auf der eigenen Webseite, von denen sich drei als praktikabel erwiesen haben. Diese werden im Folgenden evaluiert.

Verwendung des Noindex Meta Tags

Der Noindex Meta Tag signalisiert einer Suchmaschine, dass die damit ausgezeichnete Seite nicht in den Google Index aufgenommen werden soll. Dadurch wird dem Problem entgangen, dass Google selbständig eine Seite auswählt, die in den SERPs angezeigt wird. Allerdings hat diese Anwendung einen Nachteil, denn sie missachtet die Link Konsolidierung. Gerade bei dem durch verschiedene Navigationsstrukturen entstehenden Duplicate Content kann es gut möglich sein, dass auf verschiedene URLs von außen verlinkt wird. Diese geteilte Linkpower wäre damit verschwendet. Der Einsatz dieses Tags zur Duplicate Content Vermeidung ist also auf diejenigen Bereiche beschränkt, die niemals von außen verlinkt werden. Da das aber niemals zu 100% ausschließbar ist, ist im Normalfall die Verwendung des Canonical Tags vorzuziehen um dem Duplicat Content Herr zu werden.

Verwendung des Canonical Tags

Der Canonical Tag wurde im Februar 2009 vorgestellt und adressiert Duplicate Content Probleme. Der Tag wird im <head> Bereich einer HTML Seite notiert und hat die im folgenden Quellcodeausschnitt vorgestellte Syntax.

<link rel="canonical" href="http://www.example.com/canonical-target" />

Der Tag wird auf derjenigen Seite notiert, die nicht in den Ergebnissen der Suchmaschinen auftauchen soll und enthält als href Attribut die URL, die beim Ranking angezeigt werden soll. In der Wirkung ergibt sich daraus der gleiche Effekt wie bei der Verwendung des Noindex Meta Tags (im dem Sinne, dass die Seite nicht im Index auftaucht und damit auch kein Duplicate Content entsteht) wobei jedoch Ankertext und PageRank mit einem geringen Malus an das kanonikalisierte Ziel übergeben werden. Der Einsatz des Canonical Tags bietet sich für alle Duplicate Content Probleme an, bei denen die verschiedenen Inhalte zwingend über eigene URLs erreichbar sein müssen, weil sie einen eigenen Zweck erfüllen. Das ist zum Beispiel bei Druckversionen oder Faceted Navigations der Fall.

301 Redirects

Die sauberste und eindeutigste Art Duplicate Content zu bereinigen, ist das Antworten mit einem HTTP Status Code 301 (Moved Permanently) auf den Seiten, die nicht in den SERPs erscheinen sollen. Dabei wird in der HTTP Header Anweisung location: eine absolute URL angegeben, die die Ressource lokalisiert, an der sich der angeforderte Inhalt befindet. Wie auch bei dem Einsatz des Canonical Tags wird hierbei Ankertext und PageRank mit einem gewissen Malus an das Ziel der Weiterleitung weitergegeben. Diesen Malus bestätigte Matt Cutts bei dem Nachtrag eines Interviews mit Eric Enge auf stonetemple.com:

[…]Matt Cutts: That’s a good question, and I am not 100 percent sure about the answer. I can certainly see how there could be some loss of PageRank. I am not 100 percent sure whether the crawling and indexing team has implemented that sort of natural PageRank decay, so I will have to go and check on that specific case. (Note: in a follow on email, Matt confirmed that this is in fact the case. There is some loss of PR through a 301).[…]

Da die Seite weiterleitet, wird sie nicht in den Index aufgenommen, so dass kein Duplicate Content entstehen kann. Den oben angesprochenen Malus bestätigte Matt Cutts auch in einem Screencast vom 11.04.2011.

Diese sogenannten 301 Redirects werden vorrangig zur Bewältigung der mit-oder-ohne-www-Duplicate-Content-Problematik eingesetzt und eignen sich vor allem auch dann, wenn Inhalte einer alten Domain unter einer neuen verfügbar gemacht werden sollen. Die Behebung des mit-oder-ohne-www-Problems lässt sich mit einer .htaccess Datei bewerkstelligen, die im root-Verzeichnis des Webspaces abgelegt werden muss und den folgenden Inhalt hat:

RewriteEngine On

RewriteCond %{HTTP_HOST} !^www\.example\.com$ [NC]

RewriteRule ^(.*)$ http://www.example.com/$1 [R=301,L]

In diesem Fall werden sämtliche Anfragen an die mit-www-Version weitergeleitet. Generell lässt sich ein 301 Redirect auch zum Beispiel mit PHP realisieren, wie dieser Tipp zu PHP Redirects zeigt. Der 301 Redirect ist das erste Mittel um Duplicate Content zu bereinigen.

Einstellungen in den Google Webmaster Tools

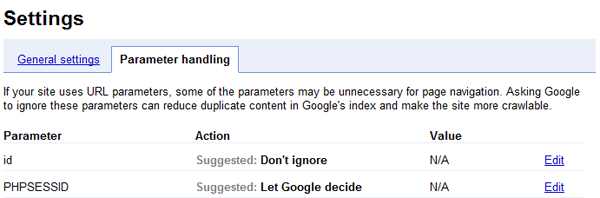

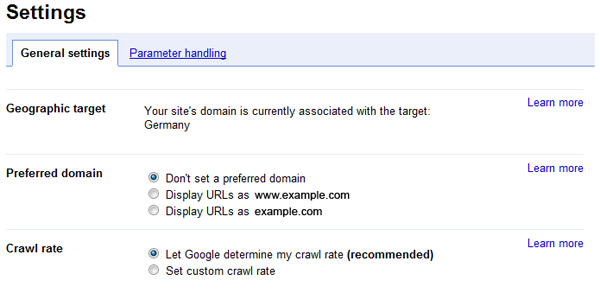

Die Google Webmaster Tools bieten Einstellungsmöglichkeiten für zwei Duplicate Content Probleme:

- Erreichbarkeit mit-und-ohne-www

- Parameter

Diese Einstellungsmöglichkeiten sind aber zum einen Google spezifisch (und zählen somit nicht für andere Suchmaschinen) und haben zum anderen keine Vorteile gegenüber den oben genannten Möglichkeiten. Sie sind hier nur aus Gründen der Vollständigkeit aufgeführt. Achtung, die Screenshots sind leider nicht mehr ganz aktuell, da Google Ende Juli 2011 das Parameterhandling angepasst hat.

Duplicate Content – Zusammenfassung

Duplicate Content liegt immer dann vor, wenn sich die URL ändert aber der Inhalt gleich bleibt. Es muss nicht einmal sein, dass der Inhalt exakt übereinstimmt, denn kleine Abweichungen werden immer noch als sogenannter Near-Duplicate Content erkannt. Wenn Google eine Webseite als Duplicate Content einstuft, dann wird diese Seite entweder nicht in den Index aufgenommen oder wird mit Nachteilen im Ranking bestraft. Im Zuge des Panda Updates aus dem Jahr 2011 geht man weiterhin davon aus, dass Duplicate Content ein Faktor ist, der sich negativ auf die dortigen Algorithmusanpassungen auswirkt.

Zum Schluss noch einmal die wichtigsten Fakten zu Duplicate Content in Kürze:

- Duplicate Content kommt zustande, wenn unterschiedliche URLs den gleichen Inhalt ausliefern

- Duplicate Content kann zur nicht-Aufnahme in den Google Index oder zu Nachteilen beim Ranking führen

- Es gibt verschiedene Möglichkeiten zur Vermeidung von Duplicate Content, diese lauten:

- NoIndex Meta Tag

- Canonical Tag

- 301 Redirect

0 comments on “Duplicate Content”